Cuando ChatGPT o Gemini dan lo que parece ser una respuesta experta a sus preguntas candentes, es posible que no se dé cuenta de cuánta información se basa para dar esa respuesta. Al igual que otros modelos populares de inteligencia artificial generativa (IA), estos chatbots se basan en sistemas de backbone llamados modelos de base que entrenan en miles de millones, o incluso billones, de puntos de datos.

En una línea similar, los ingenieros esperan construir modelos de base que entrenen a una variedad de robots en nuevas habilidades como recoger, moverse y dejar objetos en lugares como hogares y fábricas. El problema es que es difícil recopilar y transferir datos de instrucción a través de sistemas robóticos. Puede enseñar su sistema teleoperando el hardware paso a paso utilizando tecnología como la realidad virtual (VR), pero eso puede llevar mucho tiempo. La capacitación en videos de Internet es menos instructivo, ya que los clips no proporcionan un recorrido de tareas especializado y paso a paso para robots particulares.

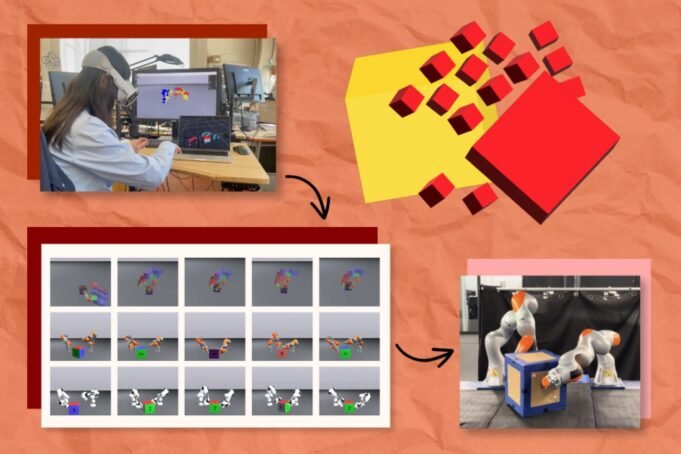

Un enfoque basado en la simulación llamado “Física” del Laboratorio de Informática e Inteligencia Artificial del MIT (CSAIL) y el Instituto Robotics y AI personaliza los datos de capacitación de robots para ayudar a los robots a encontrar los movimientos más eficientes para una tarea. El sistema puede multiplicar unas pocas docenas de demostraciones de realidad virtual en casi 3.000 simulaciones por máquina. Estas instrucciones de alta calidad se asignan a las configuraciones precisas de compañeros mecánicos como brazos robóticos y manos.

PhysicsGen crea datos que se generalizan a robots y condición específicos a través de un proceso de tres pasos. Primero, un auricular VR rastrea cómo los humanos manipulan objetos como bloques que usan sus manos. Estas interacciones se asignan en un simulador de física 3D al mismo tiempo, visualizando los puntos clave de nuestras manos como pequeñas esferas que reflejan nuestros gestos. Por ejemplo, si volteó un juguete, vería formas 3D que representan diferentes partes de sus manos que giran una versión virtual de ese objeto.

La tubería luego remapera estos puntos a un modelo 3D de la configuración de una máquina específica (como un brazo robótico), trasladándolos a las “juntas” precisas donde un sistema gira y gira. Finalmente, PhysicsGen utiliza la optimización de la trayectoria, esencialmente simulando los movimientos más eficientes para completar una tarea, por lo que el robot conoce las mejores formas de hacer cosas como reposicionar una caja.

Cada simulación es un punto de datos de entrenamiento detallado que camina un robot a través de posibles formas de manejar objetos. Cuando se implementa en una política (o el plan de acción que sigue el robot), la máquina tiene una variedad de formas de abordar una tarea y puede probar diferentes mociones si uno no funciona.

“Estamos creando datos específicos del robot sin necesidad de que los humanos vuelvan a grabar demostraciones especializadas para cada máquina”, dice Lujie Yang, estudiante de doctorado del MIT en ingeniería eléctrica e informática y afiliado de CSAIL, quien es el autor principal de un nuevo documento que presenta el proyecto. “Estamos ampliando los datos de una manera autónoma y eficiente, haciendo que las instrucciones de tareas sean útiles para una gama más amplia de máquinas”.

Generar tantas trayectorias de instrucción para robots eventualmente podría ayudar a los ingenieros a construir un conjunto de datos masivo para guiar máquinas como brazos robóticos y manos hábiles. Por ejemplo, la tubería podría ayudar a colaborar dos brazos robóticos para recoger artículos de almacén y colocarlos en las cajas correctas para entregas. El sistema también puede guiar a dos robots a trabajar juntos en un hogar en tareas como guardar copas.

El potencial de Física también se extiende a la conversión de datos diseñados para robots más antiguos o entornos diferentes en instrucciones útiles para máquinas nuevas. “A pesar de ser recolectados para un tipo específico de robot, podemos revivir estos conjuntos de datos anteriores para que los haga más útiles”, agrega Yang.

Adición por multiplicación

Physicsgen convirtió solo 24 manifestaciones humanas en miles de simuladas, ayudando a los robots digitales y digitales a reorientar objetos.

Yang y sus colegas probaron por primera vez su tubería en un experimento virtual donde una mano robótica flotante necesitaba rotar un bloque en una posición objetivo. El robot digital ejecutó la tarea a una tasa de precisión del 81 por ciento mediante la capacitación en el conjunto de datos masivo de Physicgen, una mejora del 60 por ciento de una línea de base que solo aprendió de manifestaciones humanas.

Los investigadores también encontraron que PhysicsGen podría mejorar la forma en que colaboran los brazos robóticos virtuales para manipular objetos. Su sistema creó datos de capacitación adicionales que ayudaron a dos pares de robots a lograr con éxito tareas hasta un 30 por ciento más a menudo que una línea de base puramente enseñada por humanos.

En un experimento con un par de armas robóticas del mundo real, los investigadores observaron mejoras similares a medida que las máquinas se unieron para voltear una caja grande en su posición designada. Cuando los robots se desviaron de la trayectoria prevista o manejaban el objeto, pudieron recuperar la tarea a mitad de la tarea haciendo referencia a trayectorias alternativas de su biblioteca de datos de instrucción.

El autor senior Russ Tedrake, quien es el profesor de Toyota de Ingeniería Eléctrica e Informática, Aeronáutica y Astronautia, e Ingeniería Mecánica en el MIT, agrega que esta técnica de generación de datos guiada por imitación combina las fortalezas de la demostración humana con el poder de los algoritmos de planificación de movimiento de robots.

“Incluso una sola demostración de un humano puede facilitar el problema de la planificación de la movimiento”, dice Tedrake, quien también es vicepresidente senior de modelos de gran comportamiento en el Toyota Research Institute e CSAIL Investigator. “En el futuro, quizás los modelos de la Fundación podrán proporcionar esta información, y este tipo de técnica de generación de datos proporcionará un tipo de receta posterior al entrenamiento para ese modelo”.

El futuro de Physicsgen

Pronto, PhysicsGen puede extenderse a una nueva frontera: diversificar las tareas que una máquina puede ejecutar.

“Nos gustaría usar Física para enseñarle a un robot a verter agua cuando solo ha sido entrenado para guardar platos, por ejemplo”, dice Yang. “Nuestra tubería no solo genera movimientos dinámicamente factibles para tareas familiares; también tiene el potencial de crear una biblioteca diversa de interacciones físicas que creemos que pueden servir como bloques de construcción para lograr tareas completamente nuevas que un humano no ha demostrado”.

La creación de muchos datos de capacitación ampliamente aplicables eventualmente puede ayudar a construir un modelo de base para los robots, aunque los investigadores del MIT advierten que este es un objetivo algo distante. El equipo liderado por CSAIL está investigando cómo Physicsgen puede aprovechar los vastos recursos no estructurados, como los videos de Internet, como semillas para la simulación. El objetivo: transforma el contenido visual cotidiano en datos ricos listos para el robot que podrían enseñar a las máquinas a realizar tareas que nadie las mostró explícitamente.

Yang y sus colegas también tienen como objetivo hacer que Physicsgen sea aún más útil para robots con diversas formas y configuraciones en el futuro. Para que eso suceda, planean aprovechar los conjuntos de datos con demostraciones de robots reales, capturando cómo se mueven las articulaciones robóticas en lugar de las humanas.

Los investigadores también planean incorporar el aprendizaje de refuerzo, donde un sistema de IA aprende por prueba y error, para que Physicsgen expanda su conjunto de datos más allá de los ejemplos proporcionados por los humanos. Pueden aumentar su tubería con técnicas de percepción avanzada para ayudar a un robot a percibir e interpretar su entorno visualmente, permitiendo que la máquina analice y se adapte a las complejidades del mundo físico.

Por ahora, PhysicsGen muestra cómo AI puede ayudarnos a enseñar diferentes robots a manipular objetos dentro de la misma categoría, particularmente los rígidos. La tubería pronto puede ayudar a los robots a encontrar las mejores formas de manejar elementos blandos (como las frutas) y los deformables (como la arcilla), pero esas interacciones aún no son fáciles de simular.

Yang y Tedrake escribieron el artículo con dos colegas de CSAIL: el autor co-líder y estudiante de doctorado del MIT Hyung Ju “Terry” Suh SM ’22 y el estudiante de PhD de MIT Bernhard Paus Græsdal. Los investigadores del Instituto de Robótica e IA Tong Zhao ’22, Meng ’23, Tarik Kelestemur, Jiuguang Wang y Tao Pang PhD ’23 también son autores. Su trabajo fue apoyado por el Robotics and AI Institute y Amazon.

Los investigadores recientemente presentaron su trabajo en la Conferencia de Robótica: Ciencia y Sistemas.