Enseñar a un robot nuevas habilidades utilizadas para requerir experiencia en codificación. Pero una nueva generación de robots podría aprender de casi cualquier persona.

Los ingenieros están diseñando ayudantes robóticos que pueden “aprender de la demostración”. Esta estrategia de entrenamiento más natural permite a una persona dirigir un robot a través de una tarea, generalmente de una de tres maneras: a través del control remoto, como operar un joystick para maniobrar remotamente un robot; moviendo físicamente el robot a través de los movimientos; O realizando la tarea ellos mismos mientras el robot observa e imita.

Los robots de aprendizaje por hacer generalmente entrenan en solo uno de estos tres enfoques de demostración. Pero los ingenieros del MIT ahora han desarrollado una interfaz de entrenamiento tres en uno que permite que un robot aprenda una tarea a través de cualquiera de los tres métodos de entrenamiento. La interfaz tiene la forma de una herramienta de mano equipada con sensor que puede unirse a muchos brazos robóticos colaborativos comunes. Una persona puede usar el archivo adjunto para enseñarle a un robot a llevar a cabo una tarea controlando remotamente el robot, manipulándolo físicamente o demostrar la tarea en sí mismos, cualquier estilo que prefieran o mejor se adapte a la tarea en cuestión.

El equipo del MIT probó la nueva herramienta, que llaman una “interfaz de demostración versátil”, en un brazo robótico colaborativo estándar. Los voluntarios con experiencia en fabricación utilizaron la interfaz para realizar dos tareas manuales que comúnmente se llevan a cabo en pisos de fábrica.

Los investigadores dicen que la nueva interfaz ofrece una mayor flexibilidad de capacitación que podría expandir el tipo de usuarios y “maestros” que interactúan con los robots. También puede permitir a los robots aprender un conjunto más amplio de habilidades. Por ejemplo, una persona podría capacitar de forma remota a un robot para manejar sustancias tóxicas, mientras que más abajo en la línea de producción, otra persona podría mover físicamente el robot a través de los movimientos de boxear un producto, y al final de la línea, alguien más podría usar el archivo adjunto para dibujar un logotipo de la compañía mientras el robot observa y aprende a hacer lo mismo.

“Estamos tratando de crear compañeros de equipo altamente inteligentes y hábiles que puedan trabajar de manera efectiva con los humanos para realizar un trabajo complejo”, dice Mike Hagenow, un postdoc en el MIT en el Departamento de Aeronáutica y Astronautia. “Creemos que las herramientas de demostración flexibles pueden ayudar mucho más allá del piso de fabricación, en otros dominios donde esperamos ver una mayor adopción del robot, como la configuración de hogar o cuidado”.

Hagenow presentará un artículo que detalla la nueva interfaz, en la conferencia IEEE Intelligent Robots and Systems (IROS) en octubre. Los coautores del MIT del documento son Dimosthenis Kontogiorgos, un postdoc en el MIT informática y el laboratorio de inteligencia artificial (CSAIL); Yanwei Wang PhD ’25, quien recientemente obtuvo un doctorado en ingeniería eléctrica e informática; y Julie Shah, profesora del MIT y jefa del Departamento de Aeronáutica y Astronáutica.

Entrenando juntos

El grupo de Shah en MIT diseña robots que pueden trabajar junto a los humanos en el lugar de trabajo, en los hospitales y en el hogar. Un enfoque principal de su investigación es desarrollar sistemas que permitan a las personas enseñar a los robots nuevas tareas o habilidades “en el trabajo”, por así decirlo. Dichos sistemas ayudarían, por ejemplo, a un trabajador de piso de fábrica ajustar rápida y naturalmente las maniobras de un robot para mejorar su tarea en el momento, en lugar de detenerse para reprogramar el software del robot desde cero, una habilidad que un trabajador puede no tener necesariamente.

El nuevo trabajo del equipo se basa en una estrategia emergente en el aprendizaje de robots llamado “aprendizaje de la demostración” o LFD, en el que los robots están diseñados para ser entrenados de manera más natural e intuitiva. Al mirar a través de la literatura LFD, Hagenow y Shah encontraron métodos de entrenamiento LFD desarrollados hasta ahora, generalmente en las tres categorías principales de teleperación, entrenamiento kinestésico y enseñanza natural.

Un método de capacitación puede funcionar mejor que los otros dos para una persona o tarea en particular. Shah y Hagenow se preguntaron si podían diseñar una herramienta que combine los tres métodos para permitir que un robot aprenda más tareas de más personas.

“Si pudiéramos reunir estas tres formas diferentes en que alguien podría querer interactuar con un robot, puede traer beneficios para diferentes tareas y diferentes personas”, dice Hagenow.

Tareas en cuestión

Con ese objetivo en mente, el equipo diseñó una nueva interfaz de demostración versátil (VDI). La interfaz es un accesorio portátil que puede caber en el brazo de un brazo robótico colaborativo típico. El accesorio está equipado con una cámara y marcadores que rastrean la posición y los movimientos de la herramienta con el tiempo, junto con sensores de fuerza para medir la cantidad de presión aplicada durante una tarea determinada.

Cuando la interfaz está conectada a un robot, todo el robot se puede controlar de forma remota, y la cámara de la interfaz registra los movimientos del robot, que el robot puede usar como datos de entrenamiento para aprender la tarea por sí solo. Del mismo modo, una persona puede mover físicamente el robot a través de una tarea, con la interfaz adjunta. El VDI también puede ser separado y sostenido físicamente por una persona para realizar la tarea deseada. La cámara registra los movimientos del VDI, que el robot también puede usar para imitar la tarea cuando el VBI se vuelve a colocar.

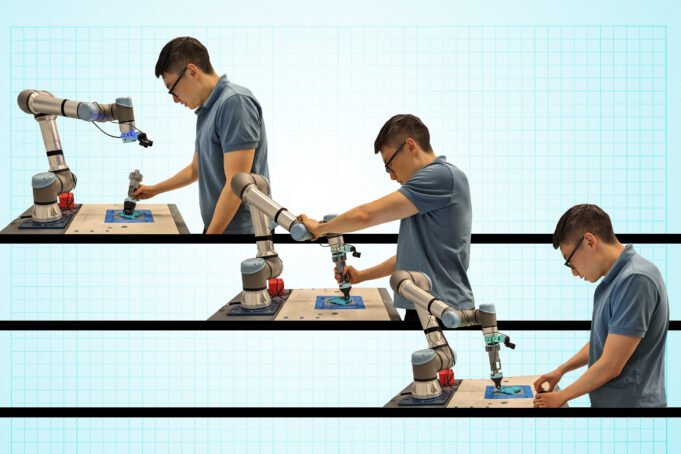

Para probar la usabilidad del archivo adjunto, el equipo llevó la interfaz, junto con un brazo robótico colaborativo, a un centro de innovación local donde los expertos en fabricación aprenden y prueban tecnología que puede mejorar los procesos de piso de fábrica. Los investigadores establecieron un experimento en el que pidieron a los voluntarios en el centro que usen el robot y los tres métodos de entrenamiento de la interfaz para completar dos tareas de fabricación comunes: ajuste de prensa y moldeo. En la ajuste de prensa, el usuario entrenó al robot para presionar y colocar clavijas en agujeros, similar a muchas tareas de fijación. Para la moldura, un voluntario entrenó al robot para empujar y rodar una sustancia gomosa de masa uniformemente alrededor de la superficie de una varilla central, similar a algunas tareas de termomolería.

Para cada una de las dos tareas, se les pidió a los voluntarios que usaran cada uno de los tres métodos de entrenamiento, primero teleoperando el robot usando un joystick, luego manipulando cinestésicamente el robot y finalmente, separando el apego del robot y usándolo para realizar “naturalmente” la tarea a medida que el robot registró la fuerza y los movimientos del accesorio.

Los investigadores encontraron que los voluntarios generalmente prefirieron el método natural sobre la teleperación y el entrenamiento kinestésico. Los usuarios, todos expertos en fabricación, ofrecieron escenarios en los que cada método podría tener ventajas sobre los demás. La teleperación, por ejemplo, puede ser preferible en la capacitación de un robot para manejar sustancias peligrosas o tóxicas. La capacitación cinestésica podría ayudar a los trabajadores a ajustar el posicionamiento de un robot que tiene la tarea de mover paquetes pesados. Y la enseñanza natural podría ser beneficiosa para demostrar tareas que involucran maniobras delicadas y precisas.

“Nos imaginamos usar nuestra interfaz de demostración en entornos de fabricación flexibles donde un robot podría ayudar en una variedad de tareas que se benefician de tipos específicos de demostraciones”, dice Hagenow, quien planea refinar el diseño del archivo adjunto en función de la retroalimentación de los usuarios y utilizará el nuevo diseño para probar el aprendizaje robot. “Vemos que este estudio demuestra cómo se puede lograr una mayor flexibilidad en los robots colaborativos a través de interfaces que amplían las formas en que los usuarios finales interactúan con los robots durante la enseñanza”.

Este trabajo fue apoyado, en parte, por el Programa de Becas Postdoctorales del MIT para la Excelencia en Ingeniería y la Beca de Investigación Postdoctoral de la Fundación Wallenberg.